Forschungsschwerpunkte des CAI

«Computer-Vision-Methoden erkennen Krebszellen oder helfen Blinden, sich in der Stadt zurechtzufinden; Chatbots beantworten Kundenfragen rund um die Uhr; und selbstfahrende Autos werden unsere Verkehrssysteme radikal verändern. Unsere Forschung strebt nach Spitzenleistungen durch praktische Anwendbarkeit.»

Anwendungsgebiete

Am CAI befassen wir uns mit der Methodik des maschinellen Lernens und des Deep Learning. Unserer Erfahrung nach lassen sich Durchbrüche in einem Anwendungsfall in der Regel gut auf andere Bereiche übertragen, da die aktuelle KI-Methodik weitgehend branchenunabhängig ist. Beispielsweise setzen wir unsere Kompetenz auf folgenden Gebieten ein:

Medizin und Gesundheit, Industrie 4.0, Robotik, vorausschauende Instandhaltung (Predictive Maintenance), automatisierte Qualitätskontrolle, Dokumentanalyse, andere Data-Science-Anwendungsfälle in Branchen wie Fertigung, Finanz und Versicherung, Detailhandel, Verkehr, digitale Landwirtschaft (Digital Farming), Wetterprognosen, Erdbeobachtung und vieles mehr.

Autonomous Learning Systems

Themen:

- Reinforcement Learning

- Multi-Agenten-Systeme

- Embodied KI

Auf dem Forschungsgebiet der autonomen Lernsysteme werden die Konzipierung und die Entwicklung intelligenter Systeme erforscht – insbesondere solcher Systeme, die eine Feedbackschleife zwischen Wahrnehmung (Verarbeitung eingehender Sensordaten) und Handlung (Ausführung von Handlungen, die einen Einfluss auf die wahrzunehmende Umgebung haben) aufweisen (Wahrnehmungs-Handlungs-Schleife). Eine wichtige Methodik hierfür ist das Deep Learning oder Reinforcement Learning, das es den Agenten ermöglicht, nach dem Trial-and-Error-Prinzip zu lernen. Dieses belohnungsbasierte Lernen wird in Zukunft völlig neue Anwendungsgebiete erschliessen, die über das übliche Lernen mittels Paaren von Input und von Hand erstelltem Output hinausgehen – und zwar in fast jeder Branche, beispielsweise in der Industrie und auf dem Gebiet der Neurotechnologien. Die Verknüpfung solcher Systeme mit Hardware, die über geeignete Sensoren und Aktoren verfügt, schafft zusätzliches Trainingspotenzial für die Algorithmen autonomer Systeme durch physische Interaktion (Verkörperung, z. B. in einer Robotikvorrichtung).

Projektbeispiel

FarmAI – Künstliche Intelligenz für den Farming Simulator

Für die weltweit erfolgreiche Videospiel-Serie «Farming Simulator» von GIANTS Software GmbH wird mittels künstlicher Intelligenz (KI) ein neuer, langfristig unterhaltender, einfach erweiterbarer Spielmodus ermöglicht. In diesem Projekt werden Reinforcement-Learning-Algorithmen eingesetzt, um durch das Simulieren von Spielen geeignete Handlungsstrategien ausfindig zu machen.

Ausgewählte Publikation

Combining Reinforcement Learning with Supervised Deep Learning for Neural Active Scene Understanding

Während das Sehen bei Lebewesen ein aktiver Prozess ist, in dem Bilderfassung und ‑klassifikation ineinandergreifen, um die Wahrnehmung schrittweise zu verfeinern, baut ein Grossteil der heutigen Computer Vision auf dem unterlegenen Paradigma der episodischen Klassifikation von i.i.d. Stichproben auf. Wir streben ein verbessertes Szenenverständnis für Roboter an, indem wir die sequenzielle Art des Sehens über die Zeit berücksichtigen. Hier präsentieren wir einen kombinierten Multitask-Ansatz aus überwachtem Lernen und Reinforcement Learning, um Fragen zu verschiedenen Aspekten einer Szene zu beantworten, z. B. zur Beziehung zwischen Gegenständen, ihrer Häufigkeit oder ihrer Position in Relation zur Kamera.

Computer Vision, Perception and Cognition

Themen:

- Mustererkennung

- Maschinelle Wahrnehmung

- Neuromorphic Engineering

Das Gebiet von Computer Vision, Wahrnehmung und Kognition ist auf die Erzeugung eines semantischen Verständnisses aus hochdimensionalen Daten-Inputs ausgerichtet. Dies geschieht zuerst durch das Erlernen und dann durch das Finden essenzieller Muster, indem maschinelle Lernmethoden und insbesondere tiefe neuronale Netze (Deep Neural Networks) in datengetriebener Weise zum Einsatz kommen (Mustererkennung). Als Input dienen beispielsweise Bilder, Videos oder andere Multimediasignale, aber auch mehrdimensionale Datenserien aus allen technischen und nicht-technischen Bereichen. Methodisch kommen Klassifikation, semantische Segmentierung und Objekterkennung zum Einsatz bei der Analyse der Inputs, oder entsprechende generative Modelle für deren Synthese (z. B. unter Verwendung sogenannter Generative Adversarial Networks). Zur Weiterentwicklung der Methodik werden zum Beispiel biologisch inspirierte Ideen aus den Neurowissenschaften verwendet (Neuromorphic Engineering).

Projektbeispiel

RealScore – Scannen von Musiknoten auf Papier für ein digitales Notenpult

Wir haben einen Musiknoten-Scan-Service geschaffen, der für qualitativ hochstehende Inputs funktioniert. Um dieses Geschäft auszubauen, sollte es sich auch für Smartphone-Bilder, gebrauchte Musikalien usw. eignen. Das Projekt RealScore erweitert das erfolgreiche Vorgängerprojekt, indem sich das Deep Learning Modell durch unüberwachtes Lernen an bislang ungesehene Daten (und deren unperfekten Zustand) anpasst.

Ausgewählte Publikation

Deep Learning mit neuronalen Netzwerken wird von immer mehr Menschen ausserhalb der klassischen Forschungslabore verwendet. Dies ist dem gewaltigen Erfolg der Methodik bei einer breiten Vielfalt an maschinellen Wahrnehmungsaufgaben zu verdanken. Auch wenn dieses Interesse durch schöne Erfolgsgeschichten genährt wird, bleibt jedoch die praktische Arbeit mit Deep Learning bei neuartigen Aufgaben ohne vorhandene Ausgangsbasis eine Herausforderung. Diese Abhandlung geht den konkreten Herausforderungen nach, die sich im Bereich realer Aufgaben stellen, und zwar auf der Basis von Fallstudien aus der Forschung und Entwicklung in Zusammenarbeit mit der Industrie, und sie zieht daraus Lehren.

Trustworthy AI

Themen:

- Vertrauenswürdiges maschinelles Lernen

- Robustes Deep Learning

- KI & Gesellschaft

Unter diesem strategischen Schwerpunktthema werden Deep Learning Verfahren untersucht, die den besonderen Anforderungen der (z.B. industriellen oder medizinischen) Praxis an Vertrauenswürdigkeit der eingesetzten Verfahren genügen: Einerseits bedeutet dies die Erzielung von Resultaten, die robust sind gegenüber leicht variierter Eingabe (etwa durch sich schleichend ändernde Umgebungen – Covariate Shift, Concept Drift – oder Adversarial Attacks) sowie robust sind trotz kleiner Trainingsmengen (Small Data bzw. Learning from Little, u.a. durch besseres Transfer Learning sowie den Einsatz von Self-Supervised und Unsupervised Learning). Andererseits heisst es, sowohl die gelernten Modelle als auch den Trainingsprozess selbst erklärbar zu machen (Explainable AI). Dies dient dem Vertrauen eines Anwenders oder Betroffenen in das System (Trustworthy AI). Regulatorische (Certifiability) und gesellschaftliche Anforderungen (z.B. Vermeidung von Algorithmic Bias) an entsprechende Systeme und wie sich diese erfüllen lassen, ist Forschungsgegenstand.

Projektbeispiel

QualitAI – Qualitätskontrolle für Industrieprodukte mittels Deep Learning für Bilder

Mit dem Projekt QualitAI wird eine vollautomatische Qualitätskontrollanlage für Industrieprodukte wie z. B. Herz-Ballonkatheter erforscht und entwickelt. Ermöglicht wird dies durch Innovationen bei der Analyse von Kamerabildern mittels Deep Learning, vor allem indem das resultierende Modell robust und interpretierbar gemacht wird.

Ausgewählte Publikation

Trace and Detect Adversarial Attacks on CNNs using Feature Response Maps

Durch die Existenz feindlicher Angriffe (Adversarial Attacks) auf sogenannte Convolutional Neural Networks (CNN) wird die Eignung entsprechender Modelle für seriöse Anwendungen in Frage gestellt. Die Angriffe manipulieren ein Input-Bild so, dass eine Fehlklassifikation entsteht, während es für einen menschlichen Beobachter immer noch normal aussieht – sie sind also nicht leicht erkennbar. In einem anderen Zusammenhang sind rückpropagierte Aktivierungen von Hidden Layers in CNN – «Feature Responses» auf einen gegebenen Input – nützlich gewesen, um für einen menschlichen Entwickler zu visualisieren, was das CNN «anschaut», während es seinen Output errechnet. Bei dieser Arbeit schlagen wir eine neuartige Nachweismethode für «feindliche» Beispiele vor, um Angriffe zu verhindern.

AI Engineering

Themen:

- MLOps

- Data-Centric AI

- Continuous Learning

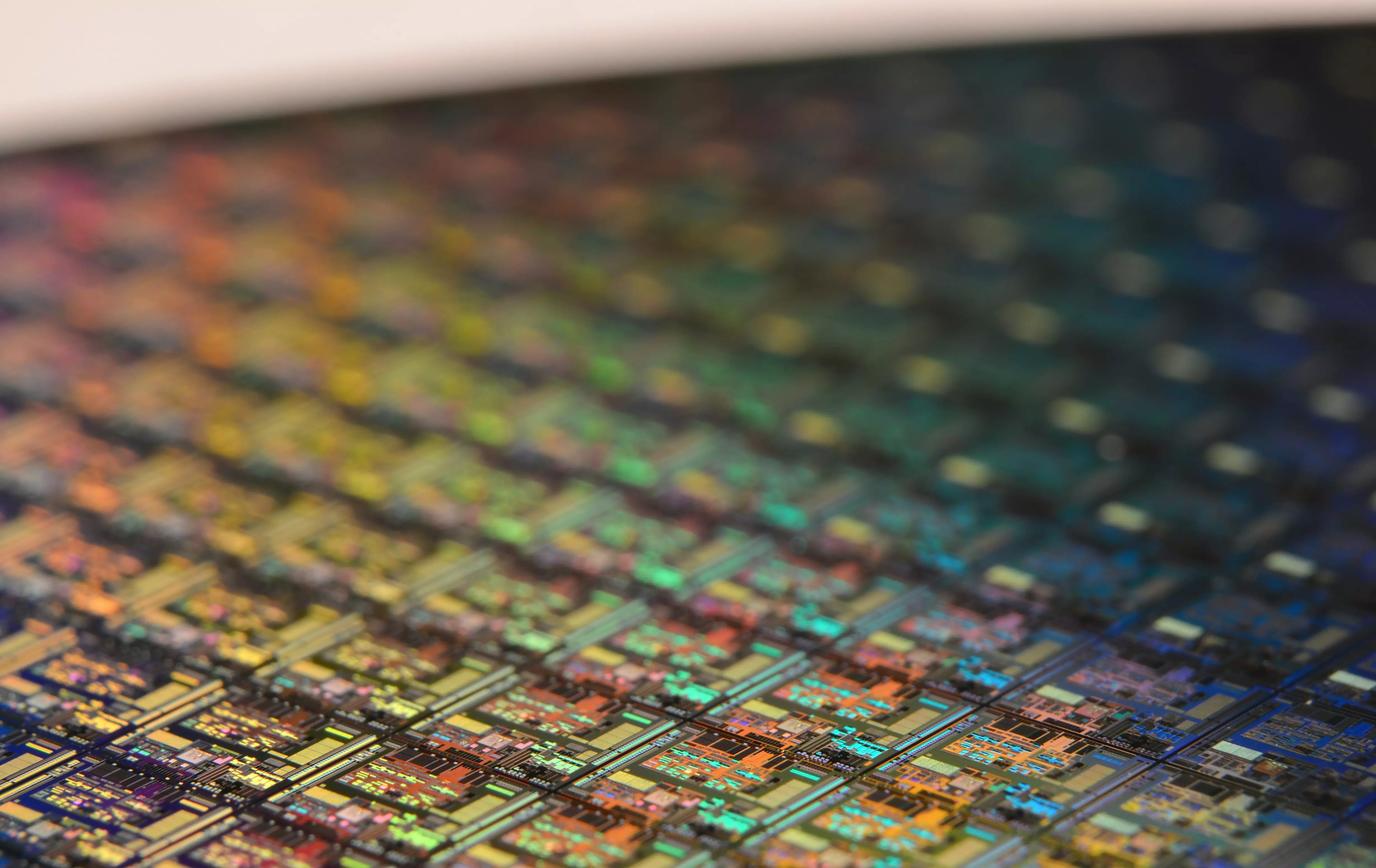

Unter diesem strategischen Schwerpunktthema werden Entwicklungsmethoden und -Prozesse zur praktischen Umsetzung der in den anderen Themenschwerpunkten behandelten Methoden in tatsächliche Systeme untersucht. Dies beinhaltet einerseits Aufbau und Weitergabe von Know-How und Tools, welche Entwicklung (Entwicklungsumgebungen, Debugging etc.), Betrieb (z.B. Deployment, Life Cycle management) sowie die Wechselwirkungen zwischen Beidem im Kontext von Machine Learning Systemen unterstützen (MLOps, GPU Cluster Computing etc.). Andererseits werden neue Wege gesucht, entsprechende Systeme mit einem Fokus auf die Optimierung der zur Verfügung stehenden Daten zu entwickeln (Data-Centric AI) und hierzu beispielsweise Machine-Learning-Unterstützen für die Sammlung, Aufbereitung und das Labeling der Daten bereitzustellen. In diesem Zusammenhang liegt ein Fokus auf der Weiterentwicklung von Ansätzen für Systeme, die kontinuierlich dazulernen anstatt lediglich einmal trainiert und dann dauerhaft eingesetzt werden (Continual Learning). Die Erkenntnisse aus diesem Themenschwerpunkt fliessen kontinuierlich in Open SourceProdukte und Demonstratoren ein.

Projektbeispiel

Pilot study machine learning for injection molding processes

Forschende des CAI und InES untersuchen im Rahmen eines technischen Deep Dive gemeinsam die Chancen, Prozesswissen über Spritzgussverfahren in Neuronalen Netzen zu bündeln und auf neue Anwendungsszenarios zu übertragen. Die Gruppen von Prof. Stadelmann (Computer Vision, Perception & Cognition, ZHAW CAI und Prof. Rosenthal (Realtime Platforms, ZHAW InES)- haben sich kürzlich mit dem Kistler Innovation Lab zusammengetan, um Risiken und Möglichkeiten zur Verbesserung der automatischen Qualitätskontrolle und Prozessüberwachung im Kunststoffspritzguss mit Hilfe von fortgeschrittenem maschinellem Lernen zu erforschen. Insbesondere werden Transfer Learning / Domain Adaptation und kontinuierliches Lernen in neuronalen Netzen für kleine Datenszenarien evaluiert. Das Team sicherte sich die Finanzierung eines technischen Deep Dives durch den NTN Databooster der Data Innovation Alliance und der Innosuisse für eine dreimonatige Studie. Die Ergebnisse werden in die Gestaltung und Umsetzung künftiger Produkte von Kistler in einem weiteren gemeinsamen Projekt einfliessen. Der NTN Databooster unterstützt datengetriebene Innovationen, indem er Unternehmen dabei hilft, passende Forschungspartner für ihre Herausforderungen zu finden, neue Lösungen zu finden, Machbarkeit und Risiken in technischen Vertiefungen zu bewerten und schliesslich eine entsprechende Finanzierung für gemeinsame F&E-Projekte zu beantragen. Mitarbeiter des CAI sind seit der Gründung des Databooster und seiner Trägerorganisation, der Data Innovation Alliance, in verschiedenen Funktionen aktiv und haben in diesem Rahmen mehrere Forschungs+Entwicklungs-Projekte erfolgreich abgeschlossen.

Ausgewählte Publikation

Design patterns for resource-constrained automated deep-learning methods

We present an extensive evaluation of a wide variety of promising design patterns for automated deep-learning (AutoDL) methods, organized according to the problem categories of the 2019 AutoDL challenges, which set the task of optimizing both model accuracy and search efficiency under tight time and computing constraints. We propose structured empirical evaluations as the most promising avenue to obtain design principles for deep-learning systems due to the absence of strong theoretical support. From these evaluations, we distill relevant patterns which give rise to neural network design recommendations. In particular, we establish (a) that very wide fully connected layers learn meaningful features faster; we illustrate (b) how the lack of pretraining in audio processing can be compensated by architecture search; we show (c) that in text processing deep-learning-based methods only pull ahead of traditional methods for short text lengths with less than a thousand characters under tight resource limitations; and lastly we present (d) evidence that in very data- and computing-constrained settings, hyperparameter tuning of more traditional machine-learning methods outperforms deep-learning systems.

Natural Language Processing (NLP)

Themen:

- Dialogsysteme

- Textanalytik

- Technologien für gesprochene Sprache

Im Schwerpunktbereich Natural Language Processing werden das maschinelle Verstehen von menschlicher Sprache in gesprochener Form (Verarbeitung gesprochener Sprache, automatische Spracherkennung, Sprecherunterscheidung) und in schriftlicher Form (Natural Language Processing, Textanalytik) untersucht, ebenso die Verwendung entsprechender maschineller Lernmethoden, wie etwa Transformer-Netze. Den Kontext dieser Forschung bilden Dialogsysteme, die eine natürlichsprachliche Kommunikation zwischen Mensch und Maschine ermöglichen. Besondere Aufmerksamkeit gilt der Entwicklung und Verfügbarkeit angepasster Methoden und Modelle für Dialekte und seltene Sprachen, für die Trainingsdaten nur beschränkt verfügbar sind. Weitere Forschungsgebiete sind die Textklassifikation (z. B. Sentiment-Analyse), Chatbots oder die Generierung von natürlicher Sprache (Natural Language Generation).

Projektbeispiel

Bei der Entwicklung kindesähnlicher Avatare für die Ausbildung von Befragern von Kindern in kriminalistischen Kontexten schliesst dieses Projekt bedeutende Erkenntnislücken hinsichtlich der Frage der Wirksamkeit einzelner Trainingselemente und personaler Einflussgrössen. Die Erkenntnisse und das Trainingstool können sowohl für die Aus- und Weiterbildung als auch für die Personalauswahl nutzbar gemacht werden Auf Grundlage dieser Erkenntnisse kann die Befragungspraxis verbessert werden und damit der internationalen Forderung nach einer kinderfreundlichen Justiz (Child-friendly Justice) entsprochen werden.

Ausgewählte Publikation

Survey on evaluation methods for dialogue systems

In dieser Abhandlung geben wir einen Überblick über die Methoden und Konzepte, die zur Evaluation von Dialogsystemen entwickelt werden. Die Evaluation ist an und für sich ein entscheidender Bestandteil des Entwicklungsprozesses. Oft werden Dialogsysteme mithilfe manueller Auswertungen und Fragebogen evaluiert. Das ist tendenziell jedoch sehr kosten- und zeitaufwändig. Deshalb wurde intensiv nach Methoden gesucht, die einen geringeren Einsatz von menschlicher Arbeit erlauben.

Publikationen

-

Zhang, Yi; Deriu, Jan Milan; Katsogiannis-Meimarakis, George; Kosten, Catherine; Koutrika, Georgia; Stockinger, Kurt,

2024.

ScienceBenchmark : a complex real-world benchmark for evaluating natural language to SQL systems.

Proceedings of the VLDB Endowment.

17(4), S. 685-698.

Verfügbar unter: https://doi.org/10.14778/3636218.3636225

-

Tuggener, Don; Niehaus, Susanna,

2024.

ERCIM News.

(136), S. 22-23.

Verfügbar unter: https://doi.org/10.21256/zhaw-29792

-

Paonessa, Claudio; Schraner, Yanick; Deriu, Jan Milan; Hürlimann, Manuela; Vogel, Manfred; Cieliebak, Mark,

2023.

Dialect transfer for Swiss German speech translation.

arXiv.

Verfügbar unter: https://doi.org/10.48550/arXiv.2310.09088

-

Cieliebak, Mark; Drewek, Anna; Jakob Grob, Karin; Kruse, Otto; Mlynchyk, Katsiaryna; Rapp, Christian; Waller, Gregor,

2023.

Winterthur:

ZHAW Zürcher Hochschule für Angewandte Wissenschaften.

Verfügbar unter: https://doi.org/10.21256/zhaw-2491

-

Bühler, Judith; Hartmann, Andrea; Tuggener, Don; Cieliebak, Mark; Baier, Dirk,

2023.

ZHAW Zürcher Hochschule für Angewandte Wissenschaften.

Verfügbar unter: https://doi.org/10.21256/zhaw-28901

Projekte

-

NLP Community Building - ComBi

SwissNLP möchte in einer konzertierten Aktion die Schweizer Akteure aus Industrie, Wissenschaft und Administration im Bereich Natural Language Processing (NLP) besser vernetzen. Dazu sollen bis Ende 2025 verschiedene Aktivitäten durchgeführt werden, um dieses Ziel zu erreichen (z.B. Expert Group Meetings, angewandte ...

-

AI4CP: AI für sich selbst-organisierende Content Plattform

In dieser Vorstudie soll ein Prototyp entwickelt werden, der aus dem Text einer Website oder eines Blog-Posts einen Vorschlag für einen Content-Post für die Conteo-Plattform erstellt. Dieser Prototyp soll vollautomatisch arbeiten, einen Text in vorgegebener Länge und Struktur erzeugen und den Post den jeweils ...

-

Towards a Voice-Based Chatbot for Language Learners (ChaLL)

Wir entwickeln ChaLL, den Prototypen eines sprachbasierten Chatbots. ChaLL bietet Sprachlerner:innen die Möglichkeit, das Sprechen in verschiedene aufgabenbasierten Konversationen zu üben und Feedback zu erhalten, frei von den zeitlichen Beschränkungen und dem Stress des klassischen Umfeldes im Klassenzimmer. ...

-

PRISM: Predicting Radicalization Events in Social Media User Timelines

Das PRISM-Projekt konzentriert sich auf die Erkennung von Radikalisierungsereignissen in Social-Media-Netzwerken. Insgesamt sind wir daran interessiert, die Mechanismen aufzudecken, die dazu führen, dass extremistische Ideologie übertragen und in die Weltanschauung eines Social-Media-Nutzers oder -Nutzerin ...

-

Evaluation automatische Spracherkennung (Schweizerdeutsch) für Menschen mit Schwerhörigkeit

Schriftdolmetschen ist eine Dienstleistung der Pro Audito für Schwerhörige/Hörbehinderte in verschiedensten Alltagssituationen. Ca. 100 Einsätze monatlich werden den Mitgliedern vermittelt, das Interesse ist aber viel grösser. Deshalb möchten wir evaluieren, inwieweit automatische Spracherkennung das ...