Ungleichbehandlung durch Gesichtserkennungsverfahren

ZHAW-Forschende finden heraus, dass Ansätze zur Reduzierung von «Biases», also Ungleichbehandlung verschiedener gesellschaftlicher Gruppen, bei der Gesichtserkennung nicht zu besseren Ergebnissen führen.

Schon jetzt ist für viele Menschen Gesichtserkennung ein ständiger Teil des Alltags, wie etwa bei der Entsperrung des Smartphones. Immer stärker wird die Technik auch bei der Verbrechensbekämpfung eingesetzt, wenn es darum geht, verdächtige Personen mithilfe von Überwachungskameras ausfindig zu machen. Problematisch daran ist – neben der zunehmenden Überwachung – dass moderne Gesichtserkennungsverfahren stark anfällig für sogenannte Biases sind, das heisst für unterschiedliche gesellschaftliche Gruppen nicht gleich gut funktionieren. Ein Team an der ZHAW hat nun herausgefunden, dass bereits angewandte Ansätze, diese Verfahren weniger anfällig für Biases zu machen, in der Praxis nicht funktionieren.

Gesichtserkennungsverfahren behandeln nicht alle gleich

Das Ziel von Gesichtserkennung ist es Gesichter zu «matchen», d.h. verschiedene Bilder der gleichen Person als solche zu identifizieren. Dies wird genutzt, um bei der Entsperrung des Smartphones zu prüfen, ob das Gesicht vor der Kamera tatsächlich dem der Besitzerin entspricht. Eine Studie hat 2018 gezeigt, dass moderne Gesichtserkennungsverfahren vor allem für Männer und Menschen mit heller Hautfarbe gut funktionieren. Insbesondere Männer mit heller Hautfarbe werden nahezu immer korrekt identifiziert. Besonders niedrig liegt die Genauigkeit dagegen bei Frauen mit dunkler Hautfarbe.

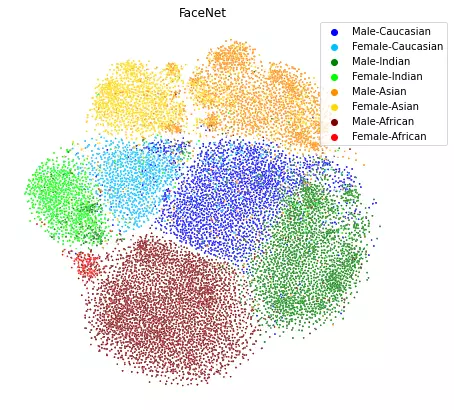

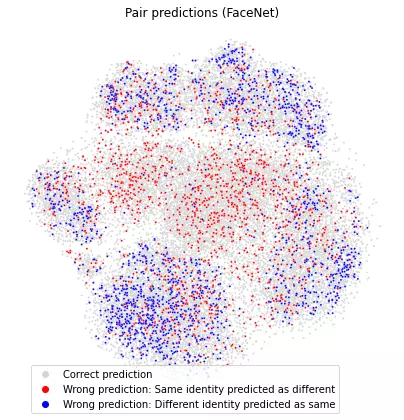

Auch in ihren Experimenten fanden die ZHAW-Forschenden diesen Bias. Zudem bemerkten sie, dass sich die gemachten Fehler deutlich zwischen den Gruppen unterscheiden. Besonders problematisch ist dies bei Anwendungen wie der Fahndung von Verdächtigen mithilfe von Gesichtserkennung. Dabei gibt es zwei Arten von Fehlern: 1) eine Person wird fälschlicherweise als verdächtige Person identifiziert oder 2) eine verdächtige Person wird nicht als solche erkannt. In den Experimenten waren bei weissen Menschen Fehler zweiter Art überwiegend, bei nicht-weissen Menschen dagegen die Fehler erster Art. So kann es für nicht-weisse Menschen besonders häufig zu ungerechtfertigten Verhaftungen kommen. Um zu testen, wie diese unterschiedlichen Levels an Fehlern verhindert werden können, haben die Forschenden der ZHAW die Methode des Blindings angewendet. Dadurch sollen die Gesichtserkennungsverfahren für bestimmte Merkmale, wie beispielsweise die Hautfarbe oder das Geschlecht, weniger empfänglich gemacht werden. Somit, so die Hoffnung, soll die Gesichtserkennung Bias-freier, also für alle Gruppen besser funktionieren. Dass dieser Ansatz nicht wie angenommen funktioniert und daher nicht zu einer Bias-freien Gesichtserkennung beiträgt, haben ZHAW-Forschende in der Studie «Bias, awareness, and ignorance in deep-learning-based face recognition» veröffentlicht. Beteiligt daran waren Samuel Wehrli von der ZHAW Soziale Arbeit, Corinna Hertweck von der School of Engineering sowie Mohammadreza Amirian und Thilo Stadelmann vom ZHAW Centre of Artificial Intelligence sowie Stefan Glüge von der ZHAW Life Science and Facility Management.

Bias-Anfälligkeit trotz Blinding

Die Forschenden fanden heraus, dass sich trotz der voreingestellten Reduzierung der Fähigkeit zum Erkennen sensibler Merkmale wie Ethnie und Geschlecht die Genauigkeit bei der Gesichtserkennung kaum verändert hat. Nach wie vor werden bei weissen Menschen weniger Fehler gemacht als bei anderen Gruppen.

Warum das so ist, liegt für Corinna Hertweck auf der Hand: «Die einzelnen Gesichtserkennungsmodelle sind zu schlecht trainiert.» Das heisst, dass die Modelle schlicht mit zu wenig Daten von unterschiedlichen soziodemografischen Gruppen ausgestattet worden sind und dadurch bei der Nutzung anfällig für Biases sind. Zwar wurde schon versucht, diese Datenlücken auszubessern, aber viele Datenerhebungen achten noch zu wenig auf die breite Repräsentation aller soziodemografischer Gruppen. Es muss daher bei der Sammlung von Trainingsdaten für Gesichtserkennungsverfahren bewusst auf mehr Diversität geachtet werden. Sonst bleiben Gesichtserkennungstechniken auch in Zukunft anfällig für Bias, sind sich die ZHAW-Forschenden sicher.

Jedoch geben die ZHAW-Forschenden auch zu bedenken, dass sich Politik und Gesellschaft generell die Frage stellen muss, in welchen Bereichen und in welchem Ausmass Gesichtserkennung im alltäglichen Leben überhaupt eingesetzt werden soll und wie der Missbrauch der Technik wirkungsvoll verhindert wird. Die Diskussion und die Antworten auf diese Fragen brauche es, damit Gesichtserkennung nicht zur Benachteiligung bestimmter soziodemografischer Gruppen führt, sondern zum Nutzen der gesamten Gesellschaft beiträgt.