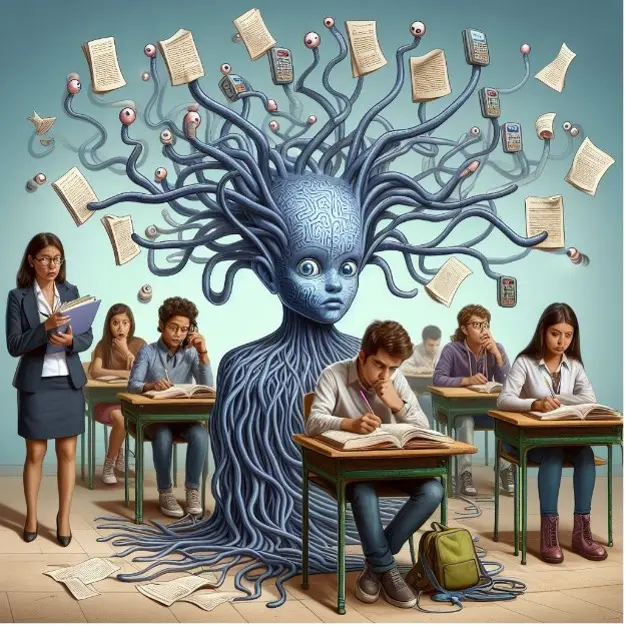

Tiefe neuronale Netze schummeln

Wie lernen moderne Modelle zur automatischen Sprechererkennung, Stimmen zu erkennen? Ein Team von UZH- und CAI-Forschern erwischt sie "in flagranti": Umfassendere dynamisch-prosodische Merkmale werden nicht einmal gezwungenermassen erlernt.

In einem kürzlich erschienenen Artikel in Patter Recognition Letters analysieren unser MSc-Absolvent Daniel Neururer, der Professor für Phonetik und Phonologie der Universität Zürich, Prof. Dr. Volker Dellwo, und unser Prof. Dr. Thilo Stadelmann, wie moderne Modelle zur automatischen Sprechererkennung Stimmen erkennen.Das Team stellt fest, dass die Modelle schummeln: Sie nehmen bewusst den einfachsten Weg und vermeiden es völlig, die schwierigeren Muster zu lernen, selbst wenn sie dazu gezwungen werden.

Diese Erkenntnis ist bedeutsam: Sie zeigt einen klaren Weg für die Forschung auf, indem sie aufzeigt, was speziell für eine bessere Sprechererkennung verbessert werden muss. Hier ist die Zusammenfassung:

Während tiefe neuronale Netze beeindruckende Ergebnisse bei der automatischen Sprechererkennung und verwandten Aufgaben gezeigt haben, ist es unbefriedigend, wie wenig man darüber weiß, was genau für diese Ergebnisse verantwortlich ist. Ein Teil des Erfolges wurde in früheren Arbeiten ihrer Fähigkeit zugeschrieben, supra-segmentale temporale Informationen (SST) zu modellieren, d.h. zusätzlich zu den spektralen Merkmalen die rhythmisch-prosodischen Eigenschaften von Sprache zu lernen. In dieser Arbeit (i) stellen wir einen neuartigen Test vor und wenden ihn an, um zu quantifizieren, inwieweit die Leistung modernster neuronaler Netze für die Sprechererkennung durch die Modellierung von SST erklärt werden kann; und (ii) stellen wir verschiedene Mittel vor, um die jeweiligen Netze zu zwingen, sich mehr auf SST zu konzentrieren und ihre Vorzüge zu bewerten. Wir stellen fest, dass eine Reihe von CNN- und RNN-basierten neuronalen Netzwerkarchitekturen für die Sprechererkennung SST nicht in ausreichendem Maße modellieren, selbst wenn sie dazu gezwungen werden. Die Ergebnisse bilden eine wichtige Grundlage für zukünftige Forschungen zur besseren Ausnutzung des gesamten Sprachsignals und geben Einblicke in das Innenleben solcher Netze, wodurch die Erklärbarkeit von Deep Learning für Sprachtechnologien verbessert wird.